"Batch Normalization"의 두 판 사이의 차이

ph

잔글 |

잔글 |

||

| (같은 사용자의 중간 판 2개는 보이지 않습니다) | |||

| 6번째 줄: | 6번째 줄: | ||

- [https://arxiv.org/abs/1502.03167 arxiv] | - [https://arxiv.org/abs/1502.03167 arxiv] | ||

| − | - [https://github.com/torch/nn/blob/master/doc/module.md#evaluate torch의 evaluate 설명] | + | - [https://github.com/torch/nn/blob/master/doc/module.md#evaluate torch의 evaluate 설명] |

| + | - [https://gab41.lab41.org/batch-normalization-what-the-hey-d480039a9e3b lab41의 요약] | ||

| + | |||

| + | -[[Neural Factorization Machines for Sparse Predictive Analytics | 마침 보던 논문]]에 나와 있던 설명 그대로 옮기면, | ||

| + | [[image:bn_nfm.png]] | ||

<disqus/> | <disqus/> | ||

2018년 8월 29일 (수) 16:43 기준 최신판

- 우리말로 된 블로그인데 설명이 아주 잘 되어 있음

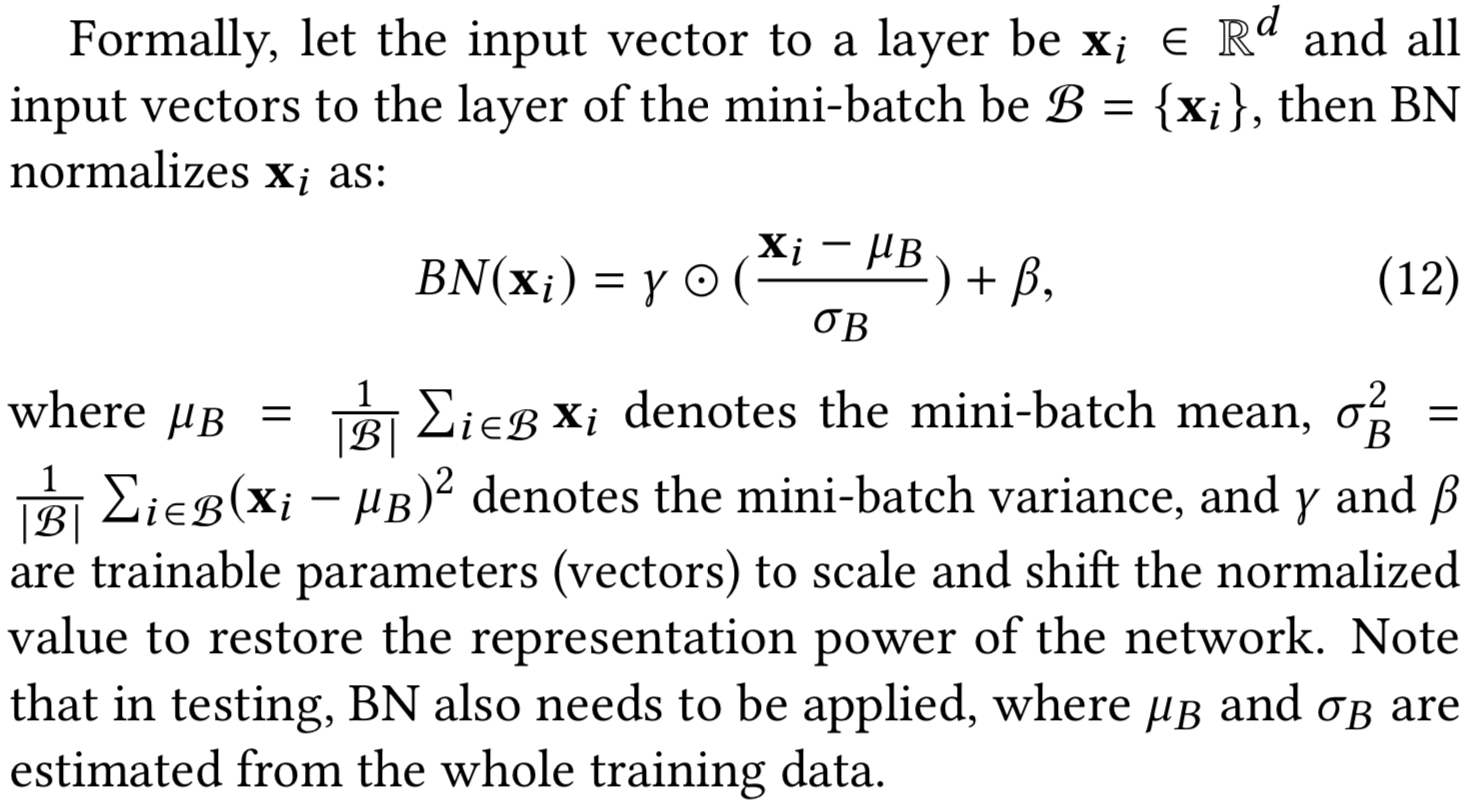

Training 할 때는 mini-batch의 평균과 분산으로 normalize 하고, Test 할 때는 계산해놓은 이동 평균으로 normalize 한다. Normalize 한 이후에는 scale factor와 shift factor를 이용하여 새로운 값을 만들고, 이 값을 내놓는다. 이 Scale factor와 Shift factor는 다른 레이어에서 weight를 학습하듯이 back-prop에서 학습하면 된다.

- CNN의 경우 채널마다 gamma, beta가 하나씩임. 곧 필터 하나에 gamma, beta 하나씩이라는 얘기.

- arxiv

- 마침 보던 논문에 나와 있던 설명 그대로 옮기면,