"DenseNet"의 두 판 사이의 차이

| 14번째 줄: | 14번째 줄: | ||

in contrast to ResNets, we never combine features through summation before they are passed into a layer; instead, we combine features by concatenating them. | in contrast to ResNets, we never combine features through summation before they are passed into a layer; instead, we combine features by concatenating them. | ||

| + | |||

| + | 전통적인 fead-foward는 state의 전이로 볼 수 있다. 정보가 단계를 거칠때마다 적절히 가공되어 필요한 정보만 남겨서 다음 상태(state)로 넘어간다. ResNet은 identity transformation을 더해서 정보의 preservation을 명확히 한 것으로 볼 수 있다. ResNet에서 layer를 randomly drop하면서 관찰해보면, 대부분의 layer가 별다른 영향을 미치지 않음을 알 수 있다<ref>G. Huang, Y. Sun, Z. Liu, D. Sedra, and K. Q. Weinberger. Deep networks with stochastic depth. In ECCV, 2016.</ref>. 마치 unrolled recurrent neural net같이 동작한다. 반면, DenseNet은 net의 입력으로 쓸 정보와 preserved되어야 하는 정보를 명확하게 구분하며, 층이 얕다.(12 feature-maps per layer) | ||

| + | |||

| + | DenseNet은 모든 layer가 input과 loss(output)에 직접 연결되어 있기 때문에, implicit deep supervision<ref>C.-Y.Lee,S.Xie,P.Gallagher,Z.Zhang,andZ.Tu.Deeply-supervised nets. In AISTATS, 2015. </ref>이 된다. | ||

| + | |||

| + | Regularizing effect도 관찰할 수 있었다. | ||

| + | |||

| + | We significantly outperform the current state-of- the-art results on most of the benchmark tasks. | ||

| + | |||

| + | =Related Work= | ||

2017년 7월 24일 (월) 12:00 판

Abstract

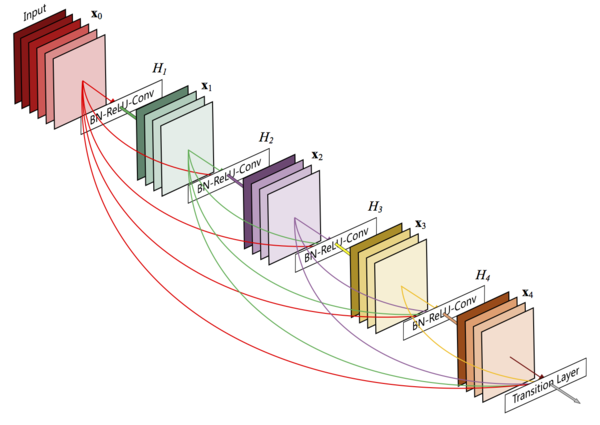

Recent work has shown that convolutional networks can be substantially deeper, more accurate, and efficient to train if they contain shorter connections between layers close to the input and those close to the output.

they alleviate the vanishing-gradient problem, strengthen feature propagation, encourage feature reuse, and substantially reduce the number of parameters.

Introduction

ResNets, Highway Networks, Stochastic depth, FractalNets, etc ... they all share a key characteristic: they create short paths from early layers to later layers.

we connect all layers. (so all connections = \(\frac{L(L-1)}{2}\) where \(L\) is the number of all layers)

in contrast to ResNets, we never combine features through summation before they are passed into a layer; instead, we combine features by concatenating them.

전통적인 fead-foward는 state의 전이로 볼 수 있다. 정보가 단계를 거칠때마다 적절히 가공되어 필요한 정보만 남겨서 다음 상태(state)로 넘어간다. ResNet은 identity transformation을 더해서 정보의 preservation을 명확히 한 것으로 볼 수 있다. ResNet에서 layer를 randomly drop하면서 관찰해보면, 대부분의 layer가 별다른 영향을 미치지 않음을 알 수 있다[1]. 마치 unrolled recurrent neural net같이 동작한다. 반면, DenseNet은 net의 입력으로 쓸 정보와 preserved되어야 하는 정보를 명확하게 구분하며, 층이 얕다.(12 feature-maps per layer)

DenseNet은 모든 layer가 input과 loss(output)에 직접 연결되어 있기 때문에, implicit deep supervision[2]이 된다.

Regularizing effect도 관찰할 수 있었다.

We significantly outperform the current state-of- the-art results on most of the benchmark tasks.